Service Navigation

Quantum Computing eröffnet neue Perspektiven

10.03.2021

Quantum Computing eröffnet neue Perspektiven

Wenn es um zukunftsweisende Innovationen im Finanzsektor geht, ist Quantum Computing auf dem Vormarsch vom theoretischen Konzept zur nächsten bahnbrechenden Technologie. Zum jetzigen Zeitpunkt ist bereits klar, dass es ein enormes Potenzial zur Lösung von bislang unlösbaren Problemen birgt. Im Rennen um die „Quantenvorherrschaft“ versuchen immer mehr Wissenschaftler, wirtschaftliche Anwendungen zu erschließen, die mit herkömmlicher IT schlichtweg nicht zu erreichen sind.

Im Rahmen ihrer strategischen Ausrichtung auf neue Technologien verfolgt die Gruppe Deutsche Börse Trends genau und beobachtet die aktuellen und künftigen Treiber unserer Branche. Wir haben deshalb ein erstes Pilotprojekt initiiert, um die Quantentechnologie auf ein reales Problem anzuwenden. Ziel ist es, unser Verständnis für die Technologie als solche sowie für deren Anwendbarkeit auf unser Geschäft zu vertiefen. Zu diesem Zweck hat die Gruppe Deutsche Börse das Frankfurter Fintech JoS QUANTUM mit der Entwicklung eines Quantenalgorithmus beauftragt, der auf bestehende Herausforderungen bei der Berechnung unserer Geschäftsrisikomodelle abzielt.

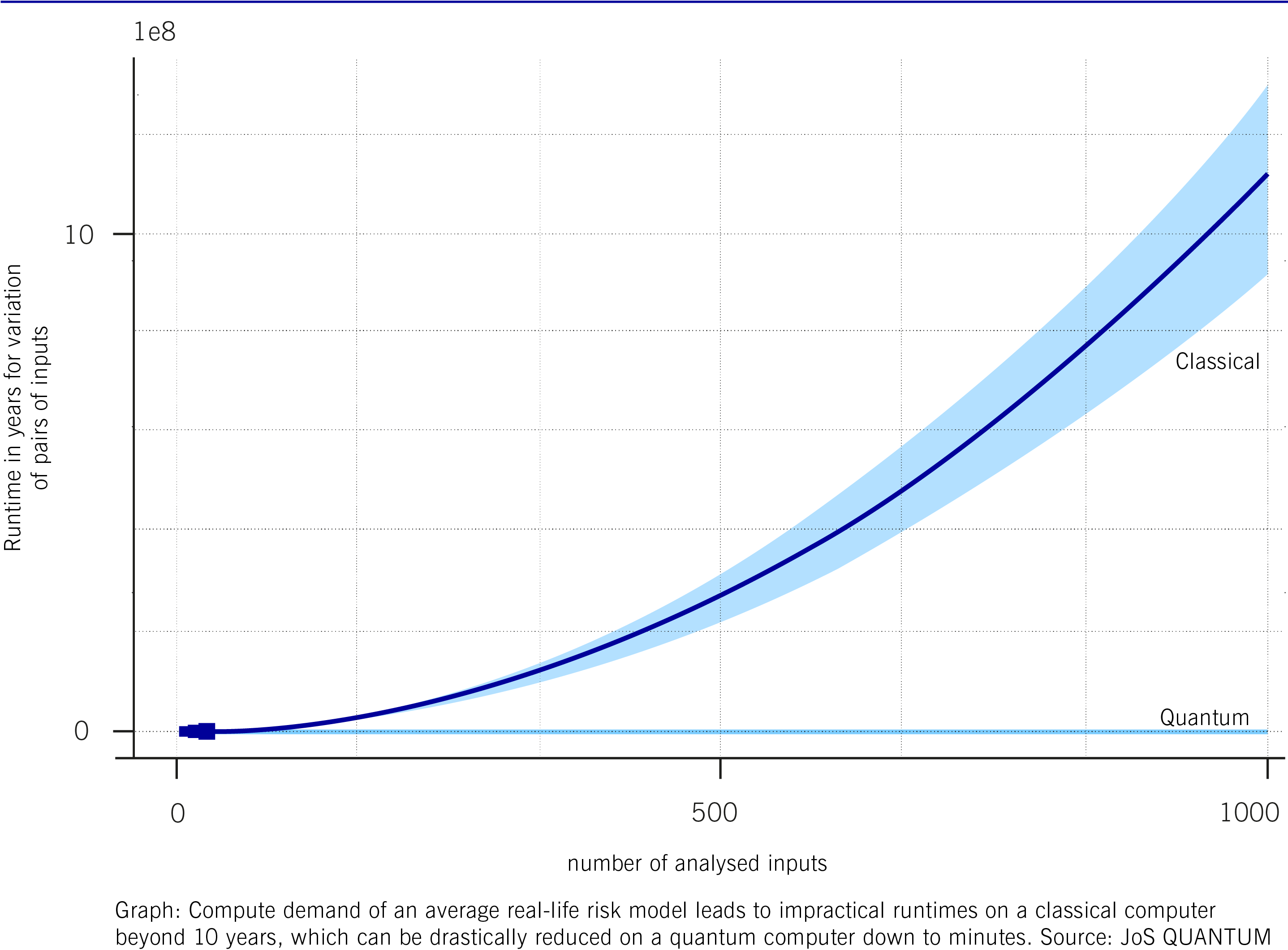

Welche Fragestellung liegt hier zugrunde? Unsere Risikomodelle werden genutzt, um die finanziellen Auswirkungen negativer externer Entwicklungen zu prognostizieren. Dazu gehören beispielsweise makroökonomische Ereignisse, Veränderungen im Wettbewerb oder neue regulatorische Rahmenbedingungen. Derzeit erfolgt die Berechnung mit Hilfe klassischer Monte-Carlo-Simulationen auf vorhandener Standard-Hardware. Abhängig von der Komplexität des Modells und der Anzahl der Simulationsparameter kann die Laufzeit zur Berechnung der Risikomodelle von einigen Minuten bis hin zu Stunden oder gar mehreren Tagen andauern. Für eine vollständige Sensitivitätsanalyse des heutigen Modells würde die Anzahl der zu analysierenden Szenarien überproportional anwachsen und damit jeglichen Rahmen an Rechenzeit sprengen. Das Pilotprojekt zielt perspektivisch auf ein System mit bis zu 1.000 Eingabeparametern ab, dessen Analyse mit Monte-Carlo-Simulationen bis zu 10 Jahre in Anspruch nehmen würde – in der Praxis haben jedoch Berechnungen, die mehr als einige Tage Rechenzeit erfordern, keinen wirtschaftlichen Nutzen.

Wie ist die Vorgehensweise? Ziel unseres Projekts war die Analyse, ob durch die Anwendung von Quantum Computing die Gesamtrechenzeit für eine vollständige Sensitivitätsanalyse deutlich reduziert werden kann – wenn möglich von mehreren Jahren auf unter 24 Stunden. Darüber hinaus wollten wir Erkenntnisse darüber gewinnen, welche Art von Quanten-Rechenleistung erforderlich wäre, um eine derartig umfangreiche Sensitivitätsanalyse perspektivisch im Tagesgeschäft durchführen zu können. Das Projekt zielte zudem auch darauf ab, ein besseres Verständnis über den Aufwand, der mit der Programmierung und Ausführung eines realen Quanten-Anwendungsfalls verbundenen ist, zu erlangen.

Drastische Reduzierung der Rechenzeit durch Quantenalgorithmen

Der erste Schritt zur Sensitivitätsanalyse des Risikomodells bestand in der Variation von Eingabeparametern von Geschäftsrisikoszenarien. Die zu erwartende Reduzierung der Rechenzeit wurde anhand eines vereinfachten Modells simuliert, indem eine sogenannte Amplitudenschätzung (die Quantenversion der Monte-Carlo-Simulation) in Kombination mit dem Grover-Algorithmus (ein Quantensuchalgorithmus) angewendet wurde. Dies ermöglicht auf Quantenmaschinen eine quadratische Beschleunigung der Berechnungen. Die Ergebnisse wurden dann mit der Laufzeit der traditionellen Monte-Carlo-Simulation auf handelsüblicher Hardware verglichen. In einem zweiten Schritt wurden die Resultate des vereinfachten Modells auf eine praxisrelevante Modellgröße extrapoliert. Es zeigt sich, dass die Anwendung von Quantum Computing den erforderlichen Rechenaufwand und damit die Gesamtberechnungszeit drastisch reduzieren würde. Für die gewählte Benchmark von 1.000 Eingaben beträgt der „Warp-Faktor“ etwa 200.000, was die handelsübliche Monte-Carlo-Rechenzeit von etwa 10 Jahren auf weniger als 30 Minuten Quantum Computing-Zeit reduzieren würde.

Der dritte Schritt war die erfolgreiche Ausführung des Modells durch die IBM Quantenmaschine („vigo“), die sich in Poughkeepsie im US-Bundesstaat New York befindet. Der Zugriff erfolgte über die IBM-Cloud. Zurzeit verfügt die Maschine nur über eine geringe Anzahl von Qubits, was die Größe des Modells begrenzt. Deshalb erfolgte die Ausführung auf der Quantenmaschine mit einer verkleinerten Version des Modells. So konnte die erfolgreiche Implementierung des Risikomodells in Quantencode verifiziert werden. Außerdem wurden die Hardware-Anforderungen für die jeweilige Anzahl und Qualität der Qubits evaluiert, um abzuschätzen, welche Generation von Quantencomputer-Hardware für eine vollständige Sensitivitätsanalyse in der Produktion benötigt werden wird. Es ist absehbar, dass diese bereits in einigen Jahren verfügbar sein wird.

Unten dargestellt sind die Ergebnisse des Vergleichs der klassischen, handelsüblichen Computerleistung mit der Quantensimulation und den Quantenmessungen.

Pilotprojekt Quantum Computing liefert vielversprechende Ergebnisse

Die Ergebnisse des Pilotprojekts haben gezeigt, dass die erwarteten Geschwindigkeitssteigerungen mit Hilfe von Quantum Computing erreicht werden können. Weiterhin haben wir ein verkürztes Risikomodell erfolgreich auf einer IBM-Quantenmaschine ausgeführt. Unserer Einschätzung zufolge wird die minimal erforderliche Quanten-Hardware für eine vollständige Modellberechnung bereits in wenigen Jahren verfügbar sein, was einen vergleichsweise überschaubaren Zeitraum darstellt. Und genau das macht dieses Projekt so einzigartig: Es ist möglich und durchaus zu erwarten, dass Anbieter von Quanten-Hardware in der Lage sein werden, diese Anforderungen in der zweiten Hälfte dieses Jahrzehnts zu erfüllen. Die reale Anwendung von Quantum Computing im Risikomanagement könnte daher nur noch eine Frage weniger Jahre sein.

Diese Entwicklung könnte neue Horizonte mit erheblichen Vorteilen eröffnen: ein ausgefeiltes, detailliertes und schnelles, aber auch robustes Risikomanagementmodell, das umfassende Sensitivitätsanalysen ermöglicht. Das Quantum Computing könnte auch für aussagekräftige Modelle schnelle Ergebnisse von praktischem Nutzen liefern. Eine Anwendung desselben quantenbasierten Ansatzes dieser Pilotstudie auf andere Bereiche des Risikomanagements ist ebenfalls denkbar, beispielsweise würden komplexere Modelle auch bei Kreditrisiken und operationelle Risiken genauere Vorhersagen ermöglichen.

Ziel des Projekts war es, Erkenntnisse über den Einsatz von Quantum Computing und die zu erwartenden Ergebnisse zu gewinnen und damit gleichzeitig die deutsche Fintech-Szene zu fördern und einen wissenschaftlichen Beitrag zu leisten. Auch wenn die breite Nutzung von Quantencomputern noch nicht in unmittelbarer Reichweite liegt, so erkennen wir aber durchaus deren enormes Potenzial und mögliche Effizienzsteigerungen, die sich für die Kapitalmärkte daraus ergeben könnten. Ferner zeigen die Ergebnisse, dass die Anwendung dieser zukunftsweisenden Technologie im Risikomanagement, einem der meist umkämpften und wichtigsten Bereiche der Finanzindustrie, erhebliche Vorteile mit sich bringen könnte.

Die ausführliche wissenschaftliche Arbeit: „A Quantum Algorithm for the Sensitivity Analysis of Business Risks“.